Jak zmieniała się wydajność CPU przez dekady?

W ciągu ostatnich kilku dekad, rozwój technologii procesorów stał się jednym z najważniejszych filarów postępu w dziedzinie informatyki. Od skromnych początków,kiedy jednostki centralne były ogromnych rozmiarów i dysponowały zaledwie kilkoma megahercami mocy,po nowoczesne architektury,które osiągają niewyobrażalne prędkości,wydajność CPU przeszła niesamowitą transformację. W miarę jak wymagania użytkowników rosną, a nowe technologie pojawiają się na rynku, producenci procesorów nieustannie muszą wdrażać innowacyjne rozwiązania, aby sprostać tym wyzwaniom. W tym artykule przyjrzymy się ewolucji wydajności jednostek centralnych na przestrzeni ostatnich dziesięcioleci, analizując kluczowe momenty w historii oraz wpływ, jaki miały one na rozwój całej branży technologicznej. Odkryjmy, jakie kamienie milowe miały największy wpływ na nasze codzienne doświadczenia z komputerami i jak mogą kształtować przyszłość tej fascynującej dziedziny!

Jak ewoluowały procesory w ostatnich dekadach

W ciągu ostatnich kilku dekad procesory przeszły niezwykłą ewolucję, dostosowując się do rosnących wymagań użytkowników i zmieniających się technologii. Wraz z rozwojem informatyki, pojawiły się nowe architektury, a także znaczący skok wydajności, który redefiniował możliwości obliczeniowe komputerów.

W latach 80. XX wieku procesory były na etapie wczesnego rozwoju. W tym czasie dominowały jednostki, takie jak Intel 8086, które oferowały niewielką moc obliczeniową, jednak stanowiły fundament dla przyszłych innowacji. były one skonstruowane głównie z myślą o prostych zadaniach biurowych, jak edytory tekstu czy arkusze kalkulacyjne.

W latach 90. nastąpił znaczący skok w technologii procesorów, co było efektem wprowadzenia architektury x86 oraz wspomagania przez procesory obliczeń w trybie wielozadaniowym. Intel Pentium z 1994 roku przyniósł rewolucję w wydajności, wprowadzając dodatkowe rdzenie i wyższe częstotliwości zegara, co zaowocowało płynniejszą wielozadaniowością.

| Rok | Model procesora | Częstotliwość (GHz) |

|---|---|---|

| 1994 | Intel Pentium | 60-300 |

| 2006 | Intel Core 2 Duo | 1.6-3.0 |

| 2017 | Intel Core i7-7700K | 4.2 |

Stulecie XXI rozpoczęło erę wielordzeniowych procesorów, gdzie pomysł dzielenia zadań na wiele rdzeni stał się standardem. AMD oraz Intel rywalizowali, wprowadzając na rynek procesory zdolne do równoczesnego przetwarzania wielu wątków, co znacząco zwiększyło wydajność w aplikacjach wymagających intensywnych obliczeń, takich jak gry czy oprogramowanie do renderowania wideo.

Obecnie, zrozumienie, jak procesory ewoluowały, wymaga analizy ich architektury. technologia 7nm oraz zmniejszenie rozmiaru tranzystorów do submikronowej wielkości pozwalają na produkcję jednostek, które są jednocześnie bardziej energooszczędne i wydajne.Kolejny krok do przodu to rozwój architektur opartych na sztucznej inteligencji, które mają na celu jeszcze bardziej zintegrowaną wydajność oraz adaptację do złożonych zadań.

Podsumowując, ewolucja procesorów w ostatnich dekadach to fascynująca podróż, która ukazuje nieustanny pościg za wydajnością i efektywnością. Inwestycje w badania i rozwój otworzyły drzwi do nowego świata technologii, gdzie przyszłość obliczeń obiecuje być jeszcze bardziej ekscytująca.

Kluczowe etapy rozwoju wydajności CPU

Wydajność procesorów przeszła znaczną ewolucję od czasów pierwszych komputerów osobistych. W miarę upływu lat, technologie produkcji, architektura procesorów oraz zmieniające się potrzeby użytkowników stawały się kluczowymi czynnikami wpływającymi na rozwój wydajności CPU.

Początki – lata 70. i 80.

W pierwszych latach komputerów osobistych, procesory były oparte na prostych architekturach. Debiut procesora Intel 4004 w 1971 roku otworzył nową erę, a jego konkurent 8086 z 1978 roku stał się fundamentem dla architektury x86, która dominuje do dziś.

Rozwój technologii – lata 90.

W latach 90. nastąpił znaczący postęp w architekturze oraz szybkości taktowania CPU. Wprowadzenie procesorów Pentium z architekturą superskalarną, które pozwalały na równoległe przetwarzanie wielu instrukcji, znacząco poprawiło wydajność. Oto kluczowe zmiany w tym okresie:

- Architektura superskalarna.

- Wzrost szybkości taktowania,dochodzący do 1 ghz.

- Wprowadzenie technologii cache do zwiększenia efektywności pamięci.

Era wielordzeniowych procesorów – lata 2000.

W początkach XXI wieku procesory zaczęły mieć wiele rdzeni, co oznaczało, że mogły wykonywać równolegle więcej zadań. Kluczowe wydarzenia, jakie miały miejsce w tym czasie to:

- Premiera procesora Intel Core Duo w 2006 roku.

- Wzrost wykorzystania multi-threading w aplikacjach.

- Innowacje w obszarze chłodzenia i zarządzania energią.

Wzrost wydajności oraz energooszczędności – lata 2010.

W ostatniej dekadzie ubiegłego wieku kluczowym trendem stały się technologie oparte na architekturze ARM, szczególnie w urządzeniach mobilnych. Procesory stały się bardziej energooszczędne przy jednoczesnym wzroście wydajności. Oto najważniejsze aspekty:

- wprowadzenie procesorów z technologią FinFET, umożliwiających miniaturyzację.

- Pojawienie się sztucznej inteligencji w obszarze przetwarzania.

- Zastosowanie nowych materiałów, takich jak grafen.

Bez wątpienia, każdy z wymienionych etapów przyczynił się do obecnej formy wydajności CPU i otworzył nowe możliwości dla przyszłości technologii komputerowej.

Zrozumienie architektury procesorów

Architektura procesorów odgrywa kluczową rolę w wydajności jednostek centralnych, a jej rozwój na przestrzeni lat jest fascynującym tematem. zmiany te, często wynikające z postępu technologicznego, zmieniały sposób, w jaki komputery przetwarzają dane, co miało bezpośredni wpływ na codzienne użytkowanie technologii.

Wczesne etapy rozwoju CPU

W latach 70-tych i 80-tych XX wieku, procesory były stosunkowo proste, często o architekturze opartej na pojedynczym rdzeniu. Przykładem może być Intel 8086, który był fundamentem dla dalszego rozwoju. Wtedy kluczowe cechy architektury obejmowały:

- 16-bitowa architektura – ograniczała ilość przetwarzanych danych na cykl.

- Minimalna pamięć cache – wpływająca na ogólną wydajność.

Era wielordzeniowa

Z czasem, w miarę rosnących wymagań obliczeniowych, architektura CPU ewoluowała w kierunku wielordzeniowości. Wprowadzenie procesorów z wieloma rdzeniami zrewolucjonizowało sposób, w jaki komputer radził sobie z równoległym przetwarzaniem danych. Do kluczowych osiągnięć należy:

- Dzięki wielordzeniowości, możliwe stało się jednoczesne wykonywanie wielu zadań.

- Wzrost efektywności energetycznej – co przyczyniło się do większej wydajności przy mniejszym zużyciu energii.

Postęp technologiczny w architekturze

Nowe technologie, takie jak Hyper-threading i zwiększona wielkość pamięci podręcznej, znacznie poprawiły wydajność CPU. Oto niektóre kamienie milowe w tej dziedzinie:

- Intel Core i7 - wprowadzenie technologii Hyper-Threading

- AMD Ryzen – konkurencja na rynku procesorów wielordzeniowych

| Rok | Model procesora | Liczba rdzeni | Częstotliwość (GHz) |

|---|---|---|---|

| 1980 | Intel 8086 | 1 | 4.77 |

| 2006 | Intel Core 2 Duo | 2 | 2.13 |

| 2017 | AMD Ryzen 7 | 8 | 3.6 |

W miarę postępu badań nad architekturą procesorów, możemy spodziewać się dalszej ewolucji, która zapewni jeszcze większe obciążenia obliczeniowe oraz możliwości przetwarzania w przyszłości. Zrozumienie tych zmian pozwala nie tylko na lepsze dostosowanie się do wymagań rynku, ale również na świadome wybory technologiczne w codziennym życiu.

Od jednordzeniowych do wielordzeniowych: rewolucja w technologii

W ciągu ostatnich dwóch dekad technologia procesorów przeszła niewyobrażalną transformację. Z punktu widzenia architektury CPU, raczej nie można już mówić o prostej liniowości: przejście od procesorów jednordzeniowych do wielordzeniowych stanowi kluczowy moment w historii obliczeń.

Wielordzeniowe procesory nie tylko zwiększyły wydajność, ale także zmieniły zasady gry w programowaniu. Zamiast jednego rdzenia wykonującego wiele zadań sekwencyjnie,nowoczesne procesory rozdzielają obciążenie na kilka rdzeni,co pozwala na efektywne wykorzystywanie zasobów i szybsze przetwarzanie danych. Oto niektóre z kluczowych korzyści, które oferują:

- Równoległość przetwarzania: Możliwość jednoczesnego wykonywania wielu zadań.

- Lepsza wydajność w zadaniach wielowątkowych: Aplikacje projektowane z myślą o wielordzeniowości, takie jak programy graficzne czy symulacje fizyczne, korzystają na tym rozwiązaniu.

- Oszczędność energii: kryteria oszczędności energetycznej stają się kluczowe, a nowe architektury efektywnie zarządzają mocą.

Patrząc na wykresy wydajności procesorów sprzed kilku lat, łatwo zauważyć, jak zaczynały się one diametralnie różnić. Właściwie, wiele z nowoczesnych technologii, takich jak AMD Ryzen czy intel Core, opiera swoje sukcesy na tej wielordzeniowej architekturze, dostosowując równocześnie swoje strategie do zapotrzebowania użytkowników. Warto również wspomnieć, że wzrost liczby rdzeni nie był jedynym czynnikiem poprawiającym wydajność.

W miarę jak zwiększała się liczba rdzeni, rozwijały się także technologie umożliwiające szybszą komunikację między nimi, takie jak Hyper-Threading czy Turbo Boost. Zmiany wprowadzone w architekturze procesorów skutkowały nie tylko lepszą wydajnością, ale także wzrostem złożoności systemów operacyjnych i aplikacji, które musiały przyszłościowo dostosować się do nowych wymagań.

| Moment w czasie | Liczba rdzeni | Typowe zastosowania |

|---|---|---|

| 2000 | 1 | Podstawowe programy, edytory tekstu |

| 2006 | 2 | Multimedia, gry |

| 2010 | 4 | Edytory wideo, rendering 3D |

| 2020 | 8+ | Sztuczna inteligencja, symulacje |

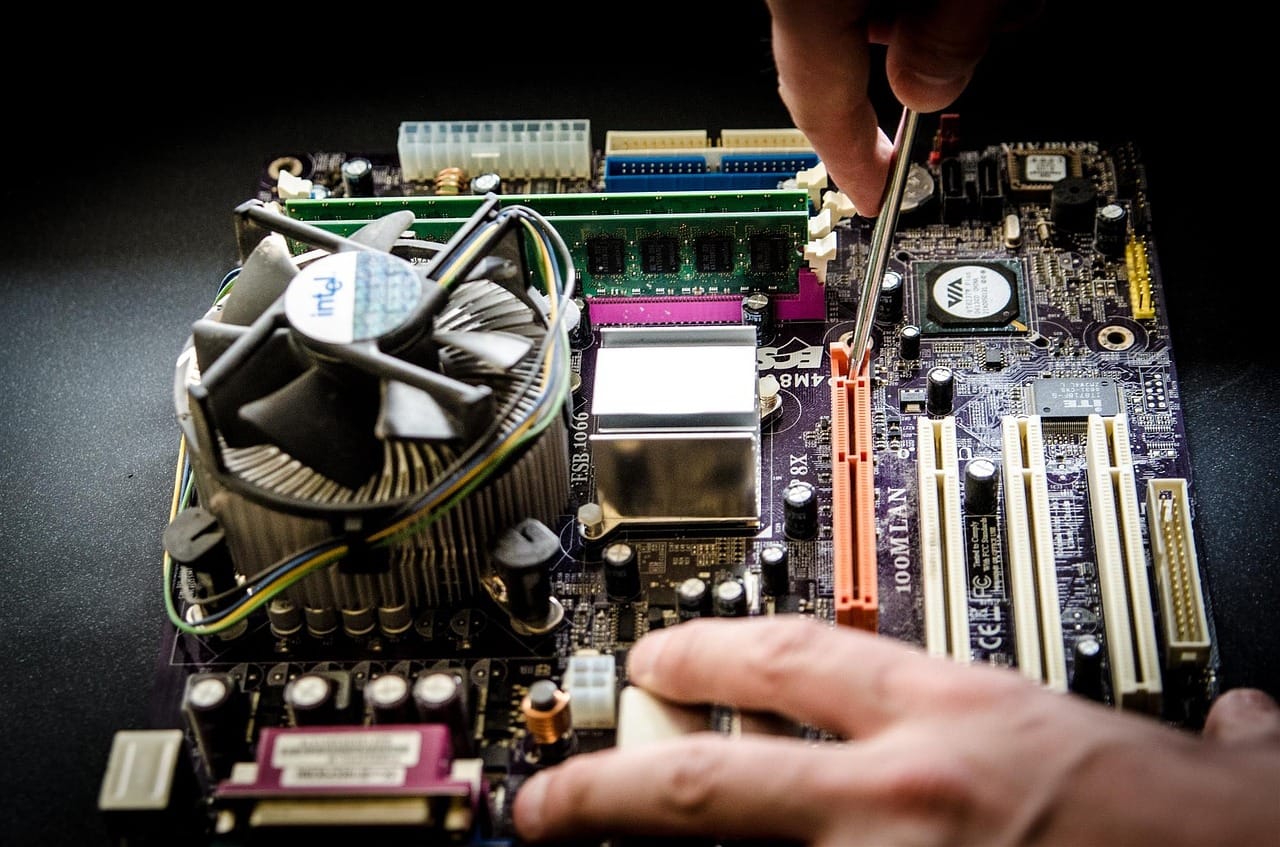

Możliwości podkręcania procesorów

Podkręcanie procesorów to jedna z najpopularniejszych praktyk wśród entuzjastów technologii oraz graczy.Dzięki niej użytkownicy mogą wydobyć dodatkową moc obliczeniową ze swojego sprzętu, co często przekłada się na lepszą wydajność w grach czy aplikacjach wymagających dużych zasobów. W ostatnich latach możliwości te stają się coraz bardziej dostępne, a także bezpieczne dzięki zaawansowanym technologiom chłodzenia i oprogramowaniu.

Wśród metod podkręcania procesorów wyróżniamy:

- Zmiana mnożnika – to klasyczna metoda, w której użytkownicy modyfikują mnożnik zegara procesora, co prowadzi do zwiększenia jego częstotliwości pracy.

- Zwiększenie napięcia – co może poprawić stabilność podkręconego procesora, ale wymaga również lepszego chłodzenia, aby uniknąć przegrzania.

- Ustawienia BIOS/UEFI – najczęściej stosowane narzędzie do modyfikacji ustawień procesora, pozwalające na precyzyjne zarządzanie wydajnością.

niemniej jednak, warto pamiętać, że podkręcanie wiąże się z pewnym ryzykiem. Procesory są projektowane z myślą o określonym poziomie wydajności, a ich nadmierne obciążenie może prowadzić do szybszego zużycia, a nawet uszkodzenia. Dlatego niezwykle istotne jest, aby korzystać z odpowiednich narzędzi monitorujących temperaturę i stabilność systemu.

| Kluczowe czynniki | Znaczenie |

|---|---|

| Chłodzenie | Wysokiej jakości system chłodzenia to podstawa efektywnego podkręcania. |

| Kompatybilność | Nie każdy procesor i płyta główna obsługują podkręcanie. Warto sprawdzić dane techniczne. |

| stabilność | Po podkręceniu, kluczowe jest przeprowadzenie testów stabilności, aby uniknąć niestabilnego działania systemu. |

Podkręcanie nie jest już zarezerwowane tylko dla najbardziej zaawansowanych użytkowników. dzięki rozwojowi technologii oraz dostępności narzędzi do łatwego ustawiania parametrów,każdy,kto ma podstawową wiedzę na temat komponentów komputerowych,może spróbować zwiększyć wydajność swojego CPU. Przy odpowiednich przygotowaniach, takiej jak zapewnienie skutecznego chłodzenia czy regularne monitorowanie parametrów pracy, można cieszyć się zwiększonymi osiągami swojego sprzętu.

Systemy chłodzenia w kontekście wydajności CPU

Wydajność procesora (CPU) jest ściśle powiązana z jego zdolnością do przetwarzania danych, a jednym z kluczowych elementów wpływających na tę wydajność są systemy chłodzenia. odpowiednie zarządzanie temperaturą komponentów komputera jest niezbędne do zachowania stabilności i efektywności działania procesora. W ciągu ostatnich kilku dekad rozwój technologii chłodzenia znacząco wpłynął na możliwości CPU.

Nowoczesne systemy chłodzenia mogą być klasyfikowane w kilka kategorii:

- Chłodzenie powietrzem – najczęściej stosowane rozwiązanie, które wykorzystuje wentylatory i radiatory do odprowadzania ciepła.

- Chłodzenie cieczą – bardziej zaawansowana technika, polegająca na cyrkulacji płynu chłodzącego przez blok wodny, co pozwala na skuteczniejsze odprowadzanie ciepła.

- Chłodzenie pasywne – systemy te nie mają wentylatorów, bazują na dużych radiatorach, co czyni je cichymi, ale również mniej efektywnymi w przypadku dużych obciążeń.

- Chłodzenie termoaktywne – rozwiązania, które wykorzystują materiały zmieniające swoje właściwości w zależności od temperatury, zapewniając lepsze odprowadzanie ciepła w krytycznych momentach.

W miarę jak procesory stają się coraz bardziej wydajne i złożone, wymagania dotyczące systemów chłodzenia muszą być na tyle elastyczne, aby sprostać tym wyzwaniom. W przypadku nowoczesnych CPU o zwiększonej liczbie rdzeni i wyższych częstotliwościach pracy, efektywność chłodzenia staje się kluczowym czynnikiem determinującym nie tylko wydajność, ale i trwałość komponentów.

W tabeli poniżej przedstawiono porównanie efektywności różnych systemów chłodzenia w kontekście ich zastosowań oraz typowych temperatur pracy procesora:

| Typ chłodzenia | Efektywność | Typowa temperatura CPU |

|---|---|---|

| Chłodzenie powietrzem | Dobre | 30-75°C |

| Chłodzenie cieczą | Bardzo dobre | 20-65°C |

| Chłodzenie pasywne | Średnie | 40-85°C |

| Chłodzenie termoaktywne | Znacząco wysokie | 15-60°C |

Podsumowując, ewolucja systemów chłodzenia jest nieodłącznym elementem rozwoju technologii CPU. Dzięki innowacjom w tej dziedzinie,producenci mogą maksymalizować wydajność procesorów,co ma kluczowe znaczenie dla użytkowników wymagających najwyższej wydajności w swoich systemach. Przyszłość chłodzenia z pewnością przyniesie kolejne przełomy, umożliwiając dalszy rozwój wydajności CPU w nadchodzących latach.

Zrozumienie taktowania zegara w procesorach

Taktowanie zegara w procesorach jest kluczowym elementem, który wpływa na ich wydajność. Jest to miara, która pozwala na określenie, jak szybko równoległe operacje i instrukcje mogą być przetwarzane przez CPU. W praktyce,im wyższe taktowanie,tym więcej cykli zegara w jednostce czasu,co przekłada się na lepszą wydajność w zadaniach wymagających dużej mocy obliczeniowej.

Wiele osób często zastanawia się, jak to działa w praktyce. Przykładowo:

- 1 GHz – oznacza miliard cykli na sekundę, co daje teoretycznie jedną miliardową możliwości wykonania instrukcji.

- Osiąganie wyższych taktowań – wymaga nie tylko zaawansowanej technologii produkcji, lecz także efektywnego chłodzenia, aby uniknąć przegrzewania się komponentów.

Warto zauważyć, że nie tylko liczba cykli zegara ma znaczenie, ale również architektura procesora. Procesory nowej generacji często osiągają wyższą wydajność przy tym samym lub niższym taktowaniu, dzięki lepszemu zarządzaniu zasobami i bardziej efektywnym algorytmom kodowania.Oto kilka kluczowych czynników, które wpływają na skuteczność taktowania:

- Inteligentne zarządzanie mocą – nowoczesne procesory są często wyposażone w systemy dynamicznej regulacji napięcia i częstotliwości, co pozwala na zwiększenie wydajności podczas intensywnego użytkowania.

- Wielordzeniowość – zamiast tłoczyć wszystko w jeden rdzeń, współczesne CPU mają wiele rdzeni, co zmienia sposób, w jaki oceniana jest wydajność względem samych GHz.

Uproszczone porównanie wydajności procesorów o różnych taktowaniach i architekturze można przedstawić w poniższej tabeli:

| Model Procesora | Taktowanie (GHz) | Rdzenie | Wydajność (pkt) |

|---|---|---|---|

| Intel i5-9600K | 3.7 | 6 | 1200 |

| AMD Ryzen 5 3600 | 3.6 | 6 | 1400 |

| Intel i9-10900K | 3.7 | 10 | 1800 |

Powyższe dane ilustrują, że sama wartość taktowania nie zawsze przekłada się na lepszą wydajność.Właściwe zrozumienie tych parametrów jest niezwykle ważne, aby móc podejmować świadome decyzje przy wyborze procesora, zwłaszcza w kontekście zastosowań, które planujemy wykonać. rozwój technologii szybko przyspiesza, co sprawia, że każdy nowy model przynosi ze sobą innowacje, które zmieniają krajobraz rynku CPU.

Rola wielkości wytwarzania w wydajności CPU

Wielkość wytwarzania procesorów ma kluczowy wpływ na ich wydajność, co nie jest zaskoczeniem w dynamicznie rozwijającym się świecie technologii. postęp technologiczny w obszarze wytwarzania chipów doprowadził do znacznego zwiększenia liczby tranzystorów, co wprost przekłada się na zdolności obliczeniowe tych urządzeń. W miarę jak technologia procesów litograficznych się rozwija, a producenci schodzą do mniejszych wymiarów, procesory stają się coraz bardziej efektywne.

W ciągu ostatnich dwóch dekad nastąpiły imponujące zmiany w architekturze procesorów, które były napędzane przez możliwe do osiągnięcia wielkości wytwarzania. Obecnie, procesory o wielkości 7 nm czy nawet 5 nm stały się normą dla czołowych producentów. Wysoka gęstość tranzystorów wpływa na:

- Wydajność obliczeniową: Więcej tranzystorów oznacza większą zdolność do przetwarzania danych jednocześnie.

- Efektywność energetyczną: Mniejsze tranzystory zużywają mniej energii, co pozwala na dłuższą pracę urządzeń bez konieczności ładowania.

- Możliwości taktowania: Zminiaturyzowane procesory mogą uzyskiwać wyższe częstotliwości taktowania, co dodatkowo zwiększa ich moc obliczeniową.

Warto również zauważyć, że wielkości wytwarzania mają wpływ nie tylko na wydajność, ale i na koszty produkcji. Wprowadzenie nowoczesnych technologii produkcji, takich jak EUV (Extreme Ultraviolet Lithography), pozwala na bardziej precyzyjne wytwarzanie, ale wiąże się również z ogromnymi inwestycjami. Równocześnie, większe moce wytwórcze prowadzą do.

| Wielkość wytwarzania (nm) | Liczba tranzystorów | Wydajność (MIPS) |

|---|---|---|

| 180 | 10M | 2000 |

| 65 | 500M | 7000 |

| 14 | 2B | 15000 |

| 7 | 10B | 30000 |

Badania nad optymalizacją procesów wytwarzania pokazują,że przyszłość technologii CPU będzie nadal ukierunkowana na zminiaturyzowane struktury,z coraz większym naciskiem na zrównoważoną produkcję. W miarę jak nowe technologie są adaptowane i rozwijane, można spodziewać się, że ich ogromny potencjał wciąż będzie wykorzystywany, aby zaspokoić potrzeby coraz bardziej wymagających aplikacji.

Jak procesory wpływają na ogólną wydajność systemu

Wydajność procesora to kluczowy element, który wpływa na całkowite działanie systemu komputerowego. W ciągu ostatnich kilku dekad, ewolucja architektury CPU oraz technologii produkcji doprowadziła do znacznej poprawy efektywności obliczeniowej. Dzięki temu, użytkownicy mogą korzystać z bardziej zaawansowanych aplikacji oraz gier, które wymagają dużej mocy obliczeniowej.

Najważniejsze czynniki wpływające na wydajność procesora to:

- Częstotliwość taktowania: Wyższa częstotliwość oznacza szybsze wykonywanie instrukcji, co przekłada się na lepszą wydajność w zadaniach jednowątkowych.

- Liczba rdzeni: Wiele rdzeni pozwala na równoległe przetwarzanie danych, co jest kluczowe dla aplikacji wielowątkowych.

- Cache: Pojemność i szybkość pamięci podręcznej wpływają na to, jak szybko procesor może uzyskać dostęp do danych.

- Architektura: Nowoczesne architektury procesorów, takie jak x86 i ARM, są zaprojektowane z myślą o optymalizacji wydajności oraz efektywności energetycznej.

Producenci procesorów, tacy jak Intel czy AMD, wprowadzają innowacje, które mają na celu zwiększenie wydajności. Przykładami są techniki takie jak:

- Turbo Boost: Automatyczne zwiększanie częstotliwości w zależności od obciążenia systemu.

- Hyper-Threading: technologia umożliwiająca jednoczesne przetwarzanie dwóch wątków na jednym rdzeniu.

- Nowe procesy technologiczne: Redukcja rozmiaru tranzystorów, co pozwala na większe gęstości i zmniejszenie zużycia energii.

W ostatnich latach wzrosło również znaczenie wydajności energetycznej. Nowoczesne procesory są projektowane tak, aby osiągnąć jak najwyższą moc przy jak najniższym zużyciu energii, co jest istotne szczególnie w urządzeniach mobilnych i laptopach.

W miarę jak technologia się rozwija, procesory będą coraz bardziej wyspecjalizowane, z naciskiem na wydajność w specyficznych zastosowaniach takich jak AI czy obliczenia w chmurze. to z kolei wpłynie na całkowitą wydajność systemu, zmieniając sposób, w jaki korzystamy z komputerów i urządzeń mobilnych.

| Generacja | Typ procesora | Przykład modelu | Częstotliwość (GHz) |

|---|---|---|---|

| 1 | CPU jedno rdzeniowy | Intel Pentium | 2.0 |

| 2 | CPU Wielordzeniowy | AMD Ryzen 5 | 3.6 |

| 3 | CPU z Hyper-Threading | Intel i7 | 4.2 |

Znaczenie pamięci podręcznej w pracy CPU

Pamięć podręczna, znana również jako cache, odgrywa kluczową rolę w wydajności procesora, stanowiąc kluczowy element architektury CPU.to szybka pamięć, która przechowuje dane i instrukcje, z których procesor korzysta najczęściej, znacząco przyspieszając czas dostępu do informacji w porównaniu do tradycyjnej pamięci RAM.

Niezwykle ważne jest zrozumienie układu i struktury pamięci podręcznej.Pamięć ta zazwyczaj dzieli się na kilka poziomów:

- L1 (Level 1) – Najszybsza i najmniejsza,zintegrowana bezpośrednio na chipie CPU.

- L2 (Level 2) – Nieco większa, ale wolniejsza od L1, również zintegrowana z procesorem.

- L3 (Level 3) – Największa i najwolniejsza spośród poziomów pamięci podręcznej, dzielona pomiędzy rdzenie procesora.

Dzięki systemowi hierarchicznemu, procesor może szybko uzyskać dostęp do danych, minimalizując opóźnienia związane z komunikacją z pamięcią główną. Przy końcu lat 80-tych, pamięć podręczna zaczęła się rozwijać, co wpłynęło na rewolucję w wydajności obliczeniowej. Wydajność CPU zaczęła rosnąć wykładniczo w miarę wzrostu wielkości i efektywności pamięci podręcznej.

Warto zauważyć, że pamięć podręczna nie tylko przyspiesza działanie aplikacji i systemów operacyjnych, ale także optymalizuje proces wczytywania danych z dysków twardych. W dzisiejszych procesorach wielordzeniowych,takie optymalizacje stają się kluczowe dla płynności działania

Rola pamięci podręcznej staje się tym bardziej znacząca wraz z rozwojem technologii,gdzie wielozadaniowość i intensywne obliczenia stają się normą. Wdrażanie coraz bardziej złożonych algorytmów w pamięci podręcznej prowadzi do poprawy wydajności w codziennych zastosowaniach.

| Typ pamięci podręcznej | Prędkość | Przykładowa pojemność |

|---|---|---|

| L1 | Bardzo wysoka | 32-64 kB |

| L2 | Wysoka | 256 kB - 8 MB |

| L3 | Umiarkowana | 2 MB – 64 MB |

Pamięć podręczna to nie tylko atrakcyjna technicznie koncepcja, ale także niezbędny element w nowoczesnych architekturach CPU, który w znaczący sposób wpływa na codzienną wydajność komputerów oraz urządzeń mobilnych.Bez jej zastosowania, osiągnięcie obecnych standardów wydajności byłoby zdecydowanie trudniejsze.

Wydajność procesora a zużycie energii

W ciągu ostatnich dekad, rozwój technologii procesorów wpływał na równowagę między wydajnością a zużyciem energii. W miarę jak procesory stawały się coraz bardziej zaawansowane, inżynierowie napotykali wyzwania związane z minimalizowaniem ich zapotrzebowania na energię, co miało kluczowe znaczenie nie tylko dla urządzeń komputerowych, ale także dla ochrony środowiska.

Najważniejsze zmiany, które miały miejsce w tym kontekście, obejmują:

- Miniaturyzacja procesorów: Dzięki zastosowaniu technologii 7nm i 5nm, możliwe było zwiększenie liczby tranzystorów na chipie, co prowadziło do poprawy wydajności przy jednoczesnym zmniejszeniu rozmiaru i zmniejszeniu poboru mocy.

- Architektura wielordzeniowa: Wprowadzenie architektur wielordzeniowych pozwoliło na obliczenia równoległe, co zwiększyło wydajność aplikacji, jednocześnie redukując zużycie energii dzięki lepszemu zarządzaniu zadaniami.

- Zarządzanie energią: Nowoczesne procesory wyposażone są w zaawansowane systemy zarządzania energią, które dostosowują wydajność do aktualnych potrzeb, pozwalając na oszczędności energetyczne w miejscach o zmniejszonym obciążeniu.

Ponadto, warto przypomnieć o rosnącym znaczeniu standardów przemysłowych, takich jak Energy Star, które promują efektywność energetyczną w urządzeniach elektronicznych, a także o wpływie regulacji rządowych, które zmuszają producentów do tworzenia komponentów o mniejszym zużyciu energii.

Patrząc na wyniki benchmarków dotyczących wydajności CPU oraz ich efektywności energetycznej, można zauważyć początkowy trend, który ujawnia zmniejszanie się „mocy obliczeniowej na wat” w starszych modelach. Oto przykładowa tabela ilustrująca ten postęp:

| Model procesora | Rok wprowadzenia | Moc (W) | Wydajność (GFlops) | Wydajność/Wat |

|---|---|---|---|---|

| Intel Core 2 Duo | 2006 | 65 | 48 | 0.74 |

| AMD Ryzen 5 3600 | 2019 | 65 | 211 | 3.24 |

| Apple M1 | 2020 | 10 | 200 | 20.00 |

W przeciągu ostatnich kilku lat, osiągnięcia w obszarze wydajności CPU i efektywności energetycznej nie tylko wpłynęły na użytkowników indywidualnych, ale także zrewolucjonizowały przemysł IT. W obliczu rosnącego zapotrzebowania na moc obliczeniową oraz dbałości o planetę, przyszłość procesorów wydaje się obiecująca, a innowacje będą wciąż kształtować ten dynamiczny rynek.

Trendy w przetwarzaniu równoległym

W miarę jak technologia rozwija się w błyskawicznym tempie, przetwarzanie równoległe staje się kluczowym elementem wydajności CPU. To podejście do obliczeń, które pozwala na jednoczesne wykonywanie wielu zadań, zdobywa coraz większą popularność w różnych dziedzinach, od nauk przyrodniczych po rozrywkę.

Wśród najważniejszych trendów w przetwarzaniu równoległym wyróżniają się:

- GPU Computing: Wykorzystanie jednostek przetwarzania graficznego (GPU) do przyspieszania obliczeń. GPU,które pierwotnie były projektowane do renderowania grafiki,sprawdzają się doskonale w złożonych obliczeniach matematycznych.

- Architektury wielordzeniowe: Nowoczesne procesory wyposażone są w wiele rdzeni, co umożliwia równoległe przetwarzanie różnorodnych zadań. Dzięki tym rdzeniom, CPU mogą efektywniej wykorzystać dostępne zasoby obliczeniowe.

- rozwiązania chmurowe: Wzrost popularności chmury obliczeniowej sprzyja rozwojowi aplikacji korzystających z przetwarzania równoległego.Zdalne serwery mogą łączyć moce obliczeniowe wielu maszyn, a tym samym przyspieszać różnorodne procesy.

- Uczenie maszynowe: Algorytmy uczenia maszynowego często wymagają olbrzymich mocy obliczeniowych, które mogą być zrealizowane dzięki równoległym procesom, co pozwala na szybsze przetwarzanie danych i generowanie wyników.

W miarę jak obliczenia stają się coraz bardziej złożone, przetwarzanie równoległe zyskuje na znaczeniu w architekturze CPU. Firmy takie jak Intel i AMD nieustannie wprowadzają innowacje, starając się nadążyć za rosnącymi wymaganiami dotyczącymi wydajności. wciąż adaptują nowe technologie, w tym takie jak:

| Technologia | Opis |

|---|---|

| Hyper-Threading | Zwiększa wydajność poprzez umożliwienie równoczesnego wykonywania dwóch wątków na jednym rdzeniu procesora. |

| SIMD (Single Instruction,Multiple Data) | Pozwala na przetwarzanie wielu elementów danych jednocześnie,znacząco przyspieszając obliczenia. |

Trendy te nie tylko zmieniają sposób, w jaki zaprojektowane są nowoczesne CPU, ale również mają znaczący wpływ na samą architekturę aplikacji. Programiści muszą dostosować swoje oprogramowanie do korzystania z mocy, jaką daje przetwarzanie równoległe, co z kolei wpływa na metodologia rozwoju oprogramowania.

Wydajność procesorów, która przez dekady nieustannie rosła, nie wydaje się zatrzymać.dzięki przetwarzaniu równoległemu jesteśmy w stanie wykorzystywać ogromny potencjał obliczeniowy, co otwiera drzwi do innowacji w wielu dziedzinach, od sztucznej inteligencji po symulacje w naukach przyrodniczych.

Wyzwania związane z miniaturyzacją układów

Miniaturyzacja układów to zjawisko, które zrewolucjonizowało branżę technologii komputerowej, lecz niesie ze sobą wiele wyzwań. W miarę jak producenci dążą do coraz mniejszych rozmiarów tranzystorów, efektywnie zwiększając liczbę rdzeni w procesorach, pojawiają się różne trudności, które należy uwzględnić.

- Problemy z odprowadzeniem ciepła: Wraz z mniejszymi rozmiarami układów, wydajność generacji ciepła wzrasta. Zarządzanie temperaturą staje się kluczowe, aby uniknąć uszkodzeń komponentów i zapewnić stabilność systemu.

- Interferencje elektromagnetyczne: Miniaturyzacja prowadzi do zwiększonej gęstości układów, co z kolei zwiększa wpływ interferencji elektromagnetycznych, co może wpływać na wydajność i stabilność pracy procesora.

- Problemy z integralnością sygnału: Wraz ze zmniejszaniem odległości między elementami układów, sygnały mogą ulegać zniekształceniom, co wpływa na ich prawidłowe działanie.

- Trudności w produkcji: Wytwarzanie coraz mniejszych tranzystorów wymaga bardziej zaawansowanych technologii, co podnosi koszty produkcji i czas realizacji projektów.

W obliczu tych wyzwań inżynierowie i naukowcy muszą podejmować nowe strategie, aby utrzymać wydajność w miarę miniaturyzacji. Przykładowo, rozwijane są techniki takie jak multi-chip module, które pozwalają na łączenie wielu układów w jednym pakiecie, a także nowe materiały dielektryczno-izolacyjne, które mogą zredukować straty sygnału.

| Wyzwanie | Możliwe rozwiązania |

|---|---|

| Odprowadzanie ciepła | Zaawansowane systemy chłodzenia, materiały o dużej przewodności cieplnej |

| Interferencje elektromagnetyczne | Stosowanie ekranów, zmiana alokacji elementów układu |

| Integralność sygnału | Technologie transmitujące wysokiej jakości sygnał, oprogramowanie do analizy |

| Produkcja | Automatyzacja, nowe materiały, poprawa procesów technologicznych |

W miarę jak będziemy zmierzać ku przyszłości, nieuniknione staje się ciągłe poszukiwanie balansów pomiędzy miniaturyzacją a wydajnością, aby sprostać rosnącym wymaganiom użytkowników na całym świecie.

Zastosowanie technologii 3D w architekturze CPU

W ostatnich latach technologie 3D zyskały ogromne znaczenie w projektowaniu architektury CPU, wprowadzając szereg innowacji, które przyczyniają się do zwiększenia efektywności oraz wydajności procesorów. Tradycyjnie projektowanie CPU polegało na dwuwymiarowym tworzeniu schematów, co ograniczało możliwość optymalizacji. Wprowadzenie modeli 3D pozwoliło inżynierom na lepsze zrozumienie złożoności topologii chipów.

Kluczowe zastosowania technologii 3D w architekturze CPU obejmują:

- optymalizacja przestrzenna: Dzięki trójwymiarowym modelom możliwe jest lepsze rozmieszczenie komponentów procesora, co minimalizuje opóźnienia w komunikacji między nimi.

- Analiza termiczna: Przy pomocy symulacji 3D inżynierowie mogą przewidzieć i zredukować problemy związane z odprowadzaniem ciepła, co jest kluczowe dla utrzymania wysokich wydajności.

- Wizualizacja procesów: 3D wizualizacje umożliwiają lepsze zrozumienie zjawisk zachodzących w czasie rzeczywistym,co jest niezwykle pomocne w fazie testowania i debugowania.

- Symulacje obciążeniowe: Dzięki modelom 3D można przeprowadzać zaawansowane symulacje różnych scenariuszy obciążenia,co sprzyja lepszemu dopasowaniu architektury do potrzeb użytkowników.

Przykładem zastosowania technologii 3D w architekturze CPU jest wprowadzenie wielordzeniowych procesorów, które wykorzystują optymalizowane struktury trójwymiarowe do zwiększenia niezawodności i wydajności. W praktyce oznacza to, że więcej rdzeni można zamknąć w mniejszej przestrzeni, co pozwala na znaczne zwiększenie mocy obliczeniowej.

Poniższa tabela ilustruje różnice w wydajności i gęstości rdzeni w różnych generacjach CPU:

| Generacja | Ps. na rdzeń | Liczba rdzeni | Gęstość (rdzeni/cm²) |

|---|---|---|---|

| 1. Gen. | 50 | 2 | 0.5 |

| 2. Gen. | 100 | 4 | 1.0 |

| 3. gen. | 200 | 8 | 1.5 |

Wprowadzenie technologii 3D w architekturze CPU stanowi krok w stronę przyszłości, w której procesory będą nie tylko szybsze, ale również bardziej energooszczędne i wydajne. Ostatecznie,zastosowanie tej technologii przyczyni się do dalszego rozwoju komputerów oraz innych urządzeń elektronicznych,które dziś uznajemy za standard.

Kiedy warto zainwestować w nowy procesor?

Decyzja o inwestycji w nowy procesor nie zawsze jest prosta i wymaga przemyślenia kilku kluczowych czynników.Warto zwrócić uwagę na kilka istotnych momentów, które mogą skłonić nas do zakupu nowego CPU:

- Starość obecnego sprzętu: Jeśli Twój procesor ma kilka lat i nie spełnia już wymagań nowoczesnych aplikacji czy gier, to zdecydowanie warto rozważyć wymianę.

- Spadek wydajności: Gdy zauważasz,że działanie systemu jest wolne,a uruchamianie programów trwa znacznie dłużej,może to być znak,że procesor wymaga wymiany.

- Nowe technologie: Wraz z rozwojem technologii pojawiają się procesory z nowymi architekturami, które oferują lepszą wydajność przy mniejszym zużyciu energii.

- Zamierzane zastosowania: Jeśli planujesz intensywnie korzystać z wymagających programów, takich jak oprogramowanie do grafiki 3D, obróbki wideo, czy najnowsze gry, nowy procesor będzie koniecznością.

- Rozbudowa systemu: Jeśli planujesz rozbudowę komputera, na przykład o więcej pamięci RAM czy lepszą kartę graficzną, warto zainwestować w mocniejszy procesor, aby uniknąć wąskich gardeł w przyszłości.

Warto również zwrócić uwagę na ceny procesorów i ich dostępność. W pewnych momentach roku, szczególnie po premierze nowych modeli, ceny starszych chipów mogą znacznie spaść. To może być idealna okazja do zakupu.

| Moment inwestycji | Powód |

|---|---|

| Starość sprzętu | Nie spełnia wymagań nowoczesnych aplikacji |

| Spadek wydajności | Wolne działanie systemu |

| Nowe technologie | Lepsza wydajność i mniejsze zużycie energii |

| Zamierzane zastosowania | wymagające programy i gry |

| Rozbudowa systemu | Uniknięcie wąskich gardeł |

Podsumowując, inwestycja w nowy procesor powinna być dobrze przemyślana i zależna od aktualnych potrzeb oraz planów związanych z użytkowaniem komputera. zrozumienie, dlaczego i kiedy warto dokonać takiej wymiany, może zaoszczędzić zarówno pieniądze, jak i frustracje związane z wydajnością sprzętu.

Jakie procesory wybierać w 2023 roku?

W 2023 roku, wybór odpowiedniego procesora stał się kluczowym zagadnieniem dla zarówno entuzjastów, jak i profesjonalistów. Oto kilka czynników, które warto wziąć pod uwagę przy podejmowaniu decyzji:

- Architektura CPU: Nowe architektury, takie jak AMD Zen 4 czy Intel Alder Lake, oferują znaczną poprawę wydajności. Warto zwrócić uwagę na procesory,które obsługują więcej rdzeni i wątków.

- wydajność energetyczna: Efektywność energetyczna jest coraz ważniejsza,zwłaszcza w kontekście rosnących cen energii. wybieraj procesory, które oferują dobrą moc obliczeniową przy niskim poborze mocy.

- Wsparcie dla najnowszych technologii: Sprawdź, czy procesor obsługuje nowoczesne technologie, takie jak DDR5, PCIe 5.0 czy Wi-fi 6,co może wpłynąć na przyszłościowy rozwój Twojego sprzętu.

- Relacja ceny do wydajności: Zrównoważony wybór pomiędzy ceną a osiągami jest kluczowy. Producenci często oferują modele o dobrej wydajności w przystępnych cenach, jak np. procesory AMD Ryzen 5 czy Intel Core i5.

- Przeznaczenie systemu: Zastanów się,do czego będziesz używać swojego PC. Inne wymagania ma gaming, a inne obróbka wideo czy programowanie. Dostosuj wybór do swoich potrzeb.

Stworzyliśmy również prostą tabelę porównawczą, by zobrazować różnice pomiędzy popularnymi procesorami dostępnymi w 2023 roku:

| Model | Liczba rdzeni | Liczba wątków | Cena (PLN) |

|---|---|---|---|

| AMD Ryzen 5 7600X | 6 | 12 | 1,199 |

| Intel Core i5-12600K | 10 | 16 | 1,399 |

| AMD Ryzen 7 7800X3D | 8 | 16 | 2,299 |

| Intel Core i7-12700K | 12 | 20 | 2,199 |

Wybór odpowiedniego procesora w 2023 roku wymaga gruntownej analizy potrzeb i priorytetów. Tylko świadome podejście do zakupu pozwoli na długoterminowe zadowolenie z inwestycji.Przeanalizuj dostępne opcje i wybierz procesor, który najlepiej spełni Twoje oczekiwania.

Znaczenie optymalizacji oprogramowania dla wydajności CPU

W dzisiejszym świecie, gdzie technologia rozwija się w zawrotnym tempie, optymalizacja oprogramowania stała się kluczowym elementem zwiększania wydajności procesorów. W miarę jak CPU stają się coraz bardziej wydajne, także oprogramowanie, które na nich działa, musi być dostosowywane, aby w pełni wykorzystać ich potencjał.

Optymalizacja oprogramowania wpływa na wiele aspektów wydajności CPU, w tym:

- Wykorzystanie zasobów: Efektywnie zaprogramowane aplikacje lepiej zarządzają pamięcią i cyklami zegarowymi, co prowadzi do mniejszego obciążenia procesora.

- Skalowalność: dobrze zoptymalizowane oprogramowanie umożliwia płynne działanie w różnych środowiskach, co zwiększa elastyczność systemów informatycznych.

- Responsywność: Aplikacje, które zostały zoptymalizowane, działają szybciej i reagują sprawniej na polecenia użytkowników, co przekłada się na lepsze doświadczenie końcowe.

Warto zauważyć,że efektywność optymalizacji nie tylko przypada na moment implementacji,ale także ewoluuje z czasem. Zmiany w architekturze CPU,takie jak wprowadzenie wielordzeniowych procesorów,stawiają nowe wymagania przed twórcami oprogramowania,którzy muszą dostosować swoje podejście do projektowania aplikacji,aby mogły one efektywnie wykorzystywać te zasoby.

Niewłaściwie zoptymalizowane oprogramowanie może prowadzić do:

- Przeciążenia CPU: Aplikacje, które nie są zoptymalizowane, mogą powodować, że procesor pracuje z maksymalnym obciążeniem, co skutkuje spadkiem wydajności.

- Wysokiego zużycia energii: Nieefektywne programy często wykorzystują więcej energii, co wpływa na koszty operacyjne.

- Pojawiania się błędów: Złożone,nieoptymalne rozwiązania mogą prowadzić do częstszych awarii i problemów w działaniu aplikacji.

W poniższej tabeli przedstawiono wpływ odpowiedniej optymalizacji na wydajność CPU w porównaniu do oprogramowania, które nie zostało dostosowane:

| Typ oprogramowania | Wydajność CPU (w %) | Zużycie energii (w W) |

|---|---|---|

| Optymalizowane | 85-95 | 30-40 |

| nieoptymalizowane | 55-70 | 50-70 |

Wnioskując, inwestycja w optymalizację oprogramowania nie tylko przyczynia się do poprawy wydajności CPU, ale także wpływa na całkowite doświadczenie użytkowników oraz efektywność operacyjną organizacji. Zmieniający się krajobraz technologiczny wymaga, aby inżynierowie z różnych dziedzin nieustannie dostosowywali swoje podejście i rozwijali umiejętności w zakresie optymalizacji oprogramowania.

Jak procesory wpływają na gaming i multimedia

W kontekście gier i multimediów, procesory odgrywają kluczową rolę w zapewnieniu płynności i jakości doświadczeń użytkownika. Z biegiem lat ich wydajność uległa znacznemu zwiększeniu, co bezpośrednio przełożyło się na rozwój technologii gamingowych oraz multimedialnych. Współczesne CPU charakteryzują się nie tylko wyższymi częstotliwościami taktowania, ale również efektywnymi architekturami, które umożliwiają równoległe przetwarzanie danych.

Jednym z ważniejszych aspektów wpływających na gry są wielordzenie. W przeszłości dominowały procesory z dwoma rdzeniami, które z czasem ewoluowały do modeli z ośmioma lub więcej rdzeniami. Dzięki temu możliwe stało się:

- Lepsze zarządzanie procesami tła, co pozwala na płynniejsze działanie gier bez opóźnień.

- Wyższa jakość grafiki w grach, ponieważ CPU współpracują z nowoczesnymi kartami graficznymi, umożliwiając lepsze renderowanie.

- Rozwój sztucznej inteligencji w grach, gdzie zaawansowane algorytmy mogą być uruchamiane w czasie rzeczywistym.

Podczas gdy procesory zajmują się obliczeniami, multiwątkowość zwiększa ich wykorzystanie w grach i programach do edycji wideo. Zastosowanie Turbo Boost i technologii Hyper-Threading przyczyniło się do maksymalizacji wydajności, co jest niezwykle istotne w wymagających środowiskach multimedialnych.

| generacja Procesorów | Rdzenie | Technologie | Główne Zastosowania |

|---|---|---|---|

| 1.Gen (2000) | 1-2 | Single-thread | Podstawowe gry, przeglądanie internetu |

| 2. Gen (2010) | 2-4 | Multi-thread | Gry 2D, multimedia w standardzie HD |

| 3. Gen (2020) | 6-16 | Turbo Boost, Hyper-Threading | Gry 3D, edycja wideo, VR |

| 4. Gen (2023) | 16-32 | AI-optimized, Advanced Multi-threading | Gry AAA, renderowanie w czasie rzeczywistym |

W kontekście multimediów, nowoczesne procesory obsługują również zaawansowane formaty wideo, takie jak 4K i 8K, co staje się standardem w branży. odtwarzanie wideo, edycja oraz streaming zyskują na rychłości i jakości dzięki lepszym algorytmom oraz wydajniejszym układom. Warto również zauważyć, że procesory są teraz w stanie przekraczać bariery, wyznaczając nowe standardy w interakcji z użytkownikiem oraz komfort pracy w programach graficznych.

Podsumowując, rozwój procesorów przez ostatnie dekady znacząco wpłynął na sposób, w jaki korzystamy z gier i mediów. Ich wydajność oraz możliwości obliczeniowe determinują przyszłość gamingowych doświadczeń, co pozwala na bardziej immersyjne i bogate w treść interakcje. Z każdym rokiem można spodziewać się coraz bardziej zachwycających efektów wizualnych i funkcjonalności, które uczynią nasze doświadczenia jeszcze bardziej niezapomnianymi.

Przyszłość procesorów: co nas czeka?

W ciągu ostatnich kilku dekad, procesory przeszły znaczącą transformację, zarówno pod względem wydajności, jak i architektury. Czekając na przyszłość, zdecydowanie warto zwrócić uwagę na nadchodzące zmiany, które mogą zrewolucjonizować nasze doświadczenie z technologią.

Nowe technologie produkcji

Wraz z miniaturyzacją technologii, wydajność procesorów zyskuje nowy wymiar. W ciągu najbliższych lat możemy spodziewać się:

- Zmniejszenia rozmiaru tranzystorów, co pozwoli na większą gęstość obliczeniową.

- Coraz bardziej zaawansowanych procesów produkcyjnych, takich jak 3nm lub 2nm, co zwiększy wydajność i efektywność energetyczną.

Architektura procesorów

Rozwój architektury będzie także kluczowym czynnikiem wpływającym na przyszłość CPU. Możemy obrazować sobie:

- Przyspieszenie rozwoju architektur heterogenicznych,które łączą różne typy rdzeni w jednym procesorze.

- Implementację technologii chipletów, które umożliwią modularne podejście do projektowania procesorów, co zwiększy elastyczność i obniży koszty produkcji.

Sztuczna inteligencja i uczenie maszynowe

Wzrost znaczenia sztucznej inteligencji wpłynie również na rozwój procesorów. Będziemy świadkami:

- Integracji specjalizowanych jednostek obliczeniowych, takich jak GPU i TPU, w celu lepszego przyspieszenia algorytmów uczenia maszynowego.

- Rozwoju architektur dedykowanych AI, co pozwoli na bardziej efektywne przetwarzanie dużych wolumenów danych.

Przyszłość zrównoważonego rozwoju

W miarę jak świat staje się coraz bardziej świadomy ekologicznie, przyszłość procesorów będzie również oscylować wokół zrównoważonego rozwoju:

- Przejrzystość produkcji oraz możliwość recyklingu komponentów.

- Opracowanie procesorów o niższym zużyciu energii bez utraty wydajności.

Podsumowując, przyszłość procesorów zapowiada się obiecująco, a nadchodzące innowacje mogą zredefiniować nasz sposób korzystania z technologii, przyspieszając rozwój wielu dziedzin życia, takich jak edukacja, medycyna czy przemysł. Czas pokaże, jakie kierunki rozwoju staną się rzeczywistością, ale jedno jest pewne – nadchodzące zmiany będą godne uwagi.

Najważniejsze firmy na rynku CPU i ich innowacje

W ciągu ostatnich kilku dekad rynek procesorów (CPU) przeżył dynamiczny rozwój, który zdominowały kilka kluczowych firm. Są one nie tylko liderami w produkcji jednostek centralnych, ale również pionierami w wprowadzaniu innowacyjnych rozwiązań technologicznych. Do najważniejszych graczy zaliczają się:

- Intel – to jedna z najstarszych i najbardziej rozpoznawalnych firm w branży.Spółka ta wprowadziła wiele innowacji, w tym architekturę x86, która zdominowała rynek komputerów osobistych.

- AMD – znana ze swojej konkurencyjnej oferty. Wprowadzenie serii Ryzen i architektury Zen przyczyniło się do wzrostu wydajności CPU i zmniejszenia kosztów w porównaniu do produktów Intela.

- NVIDIA – mimo że jest przede wszystkim znana z produkcji procesorów graficznych, firma zaczęła inwestować w procesory CPU, co spowodowało wzrost rywalizacji na rynku.

- Apple – przy pomocy własnych układów M1 i M2, firma z Cupertino zrewolucjonizowała rynek laptopów i komputerów stacjonarnych, oferując niezwykłą wydajność i efektywność energetyczną.

Każda z tych firm wprowadziła na rynek innowacje, które miały kluczowy wpływ na rozwój CPU i wydajności komputerów. Innym ważnym aspektem jest zmieniająca się architektura procesorów.Na przykład:

| Typ architektury | Firma | Innowacje |

|---|---|---|

| x86 | Intel | wielordzeniowość, Hyper-Threading |

| RISC | Apple | Architektura ARM M1 |

| Hybrid | Intel | Architektura Alder Lake |

| Zen | AMD | SMT (Simultaneous Multi-Threading) |

Powyższe innowacje ukazują, jak różnorodność podejść do projektowania procesorów wpływa na ich wydajność i zastosowania. W ciągu ostatnich lat zaobserwowaliśmy także wzrost zainteresowania procesorami zintegrowanymi, które łączą CPU i GPU w jedną jednostkę.Dzięki temu zapewniają one kompaktowość i większą efektywność energetyczną. W kontekście wydajności procesorów konieczne jest również zwrócenie uwagi na rosnące znaczenie architektur heterogenicznych, które pozwalają na lepszą adaptację do różnych zastosowań, od gier po przetwarzanie danych w chmurze.

Dzięki taki postępom, firmy te nieustannie przesuwają granice możliwości technologicznych, co w efekcie daje użytkownikom sprzęt o niespotykanej wcześniej wydajności. Na horyzoncie pojawiają się również innowacje związane z procesorami kwantowymi,co może zmienić oblicze całego rynku CPU w nadchodzących latach.

Analiza wydajności CPU w różnych zastosowaniach

Analiza wydajności procesorów CPU w różnych zastosowaniach ujawnia fascynujące zmiany, które miały miejsce przez ostatnie dekady. W miarę jak technologia rozwijała się, również różnorodność zastosowań CPU rosła. Oto kilka kluczowych obszarów, w których wydajność CPU znacząco wpłynęła na efektywność działań:

- Gry komputerowe: Wraz z pojawieniem się bardziej złożonych silników graficznych i gier 3D, CPU muszą radzić sobie z dynamicznym przetwarzaniem informacji. Nowe modele procesorów oferują większą liczbę rdzeni, co poprawia wydajność w zadaniach wielowątkowych.

- Obróbka wideo: Procesory używane w edytorach wideo zyskały na znaczeniu, wprowadzając technologie takie jak NVENC. Dzięki nim możliwe jest przyspieszenie procesów renderowania, co wcześniej zajmowało godziny, teraz potrafi zająć tylko kilka minut.

- Uczenie maszynowe i AI: Wydajność CPU jest kluczowa w trenowaniu modeli AI. Wyposażone w funkcje przyspieszające obliczenia, nowoczesne procesory pozwalają na zwiększenie efektywności przetwarzania danych dużej skali.

| Zastosowanie | Wydajność CPU (średni wzrost) | Kluczowe cechy |

|---|---|---|

| Gry komputerowe | 60% | Wielordzeniowość,optymalizacja dla gier |

| Obróbka wideo | 75% | Akceleracja sprzętowa,szybkie kodowanie |

| Uczenie maszynowe | 90% | Wsparcie dla obliczeń równoległych,zwiększone pamięci podręczne |

Obserwacje wskazują,że wydajność CPU nie tylko rośnie,ale również dostosowuje się do potrzeb rynku i oczekiwań użytkowników. Wydajność tych procesorów jest kluczowa nie tylko dla graczy, ale także dla profesjonalistów zajmujących się tworzeniem treści oraz inżynierów zajmujących się projektowaniem systemów sztucznej inteligencji.

W miarę jak świadomość dotycząca znaczenia wydajności CPU wzrasta, można zauważyć rosnące zainteresowanie rywalizacją na rynku procesorów. Zmieniające się wymagania dają impulsy do innowacji, co z kolei przyspiesza rozwój technologii, co jest niewątpliwie korzystne dla użytkowników.

Jak testować wydajność swojego procesora?

Testowanie wydajności procesora to kluczowy krok, jeśli chcemy zrozumieć, jak radzi sobie nasz sprzęt w różnych sytuacjach. Istnieje kilka narzędzi oraz metod, które pozwalają na dokładną analizę działania CPU. Poniżej przedstawiamy kilka z nich:

- Benchmarki syntetyczne: To specjalne programy, które symulują różne zadania obliczeniowe, a następnie analizują rezultaty. Popularne narzędzia to Geekbench, Cinebench czy 3DMark.

- Testy w rzeczywistych warunkach: Użycie programów takich jak Prime95 czy AIDA64 do obciążania procesora może pomóc w ocenie jego wydajności w praktyce.

- Monitoring temperatury: Użycie narzędzi takich jak hwmonitor czy Core Temp do śledzenia temperatury CPU podczas testów jest istotne, by upewnić się, że procesor nie przegrzewa się.

- Zbieranie danych o obciążeniu: Należy śledzić, w jaki sposób procesor radzi sobie z różnymi typami obliczeń – od zadań jednowątkowych po obliczenia wielowątkowe.

Podczas testowania warto również zwrócić uwagę na czynniki zewnętrzne, takie jak:

- optimizacja systemu operacyjnego,

- wersja sterowników,

- zainstalowane oprogramowanie, które może wpływać na wydajność.

Również zaleca się przeprowadzenie kilku testów w różnych warunkach, aby uzyskać bardziej kompleksowy obraz wydajności. Można stworzyć tabelę porównawczą, aby zobaczyć różnice w wydajności CPU przed i po zastosowaniu podkręcania lub zmianie chłodzenia.

| Test | Wynik przed | Wynik po |

|---|---|---|

| Geekbench | 7500 | 8500 |

| Cinebench R20 | 2000 | 2300 |

| Prime95 | 65°C | 75°C |

Testując wydajność swojego procesora, pamiętaj o dokładnej analizie wyników oraz ich kontekście. Tylko w ten sposób można uzyskać pełny obraz możliwości naszego CPU i podjąć świadome decyzje dotyczące jego usprawnień.

Porady dla entuzjastów podkręcania procesorów

Podkręcanie procesorów stało się popularnym hobby dla wielu entuzjastów komputerowych,ale aby czerpać z tego pełne korzyści,warto znać kilka istotnych zasad i technik.Poniżej znajdziesz praktyczne wskazówki, które pomogą Ci w wydobywaniu maksimum z Twojego CPU.

- Zrozum swój procesor: Przed przystąpieniem do podkręcania, zainwestuj czas w zrozumienie architektury swojego procesora. Każda seria ma swoje limity, które warto poznać.

- Chłodzenie: Upewnij się, że masz odpowiednie chłodzenie. wysokowydajne wentylatory i systemy chłodzenia cieczą mogą znacznie poprawić stabilność podczas podkręcania.

- Czujniki temperatury: monitoruj temperatury CPU podczas obciążenia. Używaj oprogramowania takiego jak HWMonitor, aby zyskać wgląd w parametry pracy.

- Stopniowe zwiększanie taktowania: Podnoś taktowanie w małych krokach, aby ocenić stabilność systemu na każdym etapie. Przeprowadzaj testy stabilności, takie jak Prime95, po każdej zmianie.

- Ustawienia BIOS: Poznaj ustawienia w BIOSie swojej płyty głównej. Opcje takie jak napięcia Vcore czy mnożnik BCLK są kluczowe w procesie podkręcania.

| Typ procesora | Max. bezpieczne taktowanie | Rekomendowane chłodzenie |

|---|---|---|

| intel i5 | 4.5 GHz | Chłodzenie powietrzne wysokiej wydajności |

| AMD Ryzen 5 | 4.2 GHz | Chłodzenie cieczą AIO |

| Intel i7 | 4.8 GHz | Chłodzenie cieczą dedykowane |

Pamiętaj, że każdy procesor jest inny, a wyniki podkręcania mogą się różnić w zależności od konkretnego egzemplarza. Kluczem do sukcesu jest cierpliwość i dbałość o szczegóły. Przestrzegaj podstawowych zasad, a Twoje doświadczenia z podkręcaniem mogą przynieść satysfakcjonujące rezultaty. W końcu każdy megaherc więcej może znacząco wpłynąć na wydajność Twojego systemu.

Wydajność CPU w kontekście sztucznej inteligencji

W ciągu ostatnich dwóch dekad, wydajność procesorów (CPU) uległa znacznemu poprawieniu, co miało bezpośredni wpływ na rozwój sztucznej inteligencji. Wzrost mocy obliczeniowej spowodował, że algorytmy AI mogły przetwarzać coraz większe zestawy danych oraz realizować bardziej skomplikowane obliczenia w krótszym czasie.

Główne trendy rozwoju wydajności CPU:

- Miniaturyzacja: Postępująca miniaturyzacja układów scalonych pozwala na umieszczanie większej liczby rdzeni w tym samym obszarze, co zwiększa wydajność obliczeniową.

- Architektura wielordzeniowa: Wprowadzenie procesorów z wieloma rdzeniami znacząco wpłynęło na zdolności równoległego przetwarzania danych, co jest kluczowe w aplikacjach AI.

- Specjalizacja: wzrost wykorzystania akceleratorów GPU oraz układów FPGA do zadań związanych z uczeniem maszynowym pozwolił na jeszcze lepszą optymalizację procesów obliczeniowych.

Warto zauważyć,że nie tylko szybkość zegara procesora jest istotna w kontekście sztucznej inteligencji,ale także jego zdolność do efektywnego zarządzania przepływem danych. W odpowiedzi na rosnące zapotrzebowanie na moc obliczeniową, producenci wprowadzają innowacje, które optymalizują architekturę CPU oraz poprawiają komunikację między rdzeniami.

Porównanie wydajności CPU w kontekście miłości do AI:

| Rok | Model CPU | Rdzenie | Maks. Taktowanie (GHz) |

|---|---|---|---|

| 2000 | Pentium 4 | 1 | 1.5 |

| 2010 | Core i7 | 4 | 3.33 |

| 2020 | Ryzen 9 | 12 | 4.8 |

Zmieniająca się architektura oraz rosnąca liczba rdzeni idealnie wpisują się w potrzeby nowoczesnych aplikacji AI, które wymagają zaawansowanego przetwarzania równoległego. Przy rozwoju takich technologii, jak uczenie głębokie, kluczowe stało się dostosowanie mocy obliczeniowej do specyfiki zadań, co z kolei napędza innowacje w projektowaniu CPU.

Choć wiele osób koncentruje się na przyszłości związanej z GPU i innymi akceleratorami sztucznej inteligencji, procesory CPU wciąż zyskują na znaczeniu jako fundamenty systemów obliczeniowych. To równocześnie świadczy o ich ewolucji i konieczności dostosowania do wymagań szybko rozwijającego się świata technologii.

Historie sukcesów: jakie procesory zmieniły rynek?

W ciągu ostatnich kilku dekad rynek procesorów przeszedł niebywałą transformację, a niektóre jednostki centralne zapisały się na kartach historii technologii jako prawdziwe przełomy. Oto kilka procesorów,które znacząco wpłynęły na wydajność i architekturę CPU,redefiniując sposób,w jaki korzystamy z komputerów.

Intel 4004: Wydany w 1971 roku, był pierwszym na świecie mikroprocesorem. Jednostka ta zmieniła sposób, w jaki projektowano komputery, wprowadzając ideę systemu opartego na procesorze, co zaowocowało rozwojem komputerów osobistych.

Intel 8086: Wprowadzony w 1978 roku, ten procesor stał się podstawą architektury x86, która dominuje w komputerach PC do dziś. Jego 16-bitowa architektura umożliwiła rozwój bardziej zaawansowanych aplikacji i systemów operacyjnych.

processor from AMD – Athlon 64: W 2003 roku AMD wprowadziło na rynek Athlon 64, pierwszy procesor z architekturą x86-64, co otworzyło drzwi do obsługi pamięci powyżej 4 GB.Ten innowacyjny ruch umożliwił graczom i profesjonalistom pracującym z zasobochłonnymi programami znacznie lepsze wykorzystanie możliwości sprzętu.

Intel Core i7: Wprowadzony w 2008 roku, ten procesor z linii Nehalem zrewolucjonizował wydajność komputerów stacjonarnych i laptopów. Dzięki wielowątkowości oraz zwiększonej efektywności energetycznej, Core i7 stał się ulubieńcem wśród graczy oraz profesjonalistów.

| Nazwa procesora | Rok wydania | Kluczowa innowacja |

|---|---|---|

| Intel 4004 | 1971 | Pierwszy mikroprocesor |

| Intel 8086 | 1978 | Architektura x86 |

| Athlon 64 | 2003 | Architektura x86-64 |

| Intel Core i7 | 2008 | Wielowątkowość |

Każdy z wymienionych procesorów nie tylko dostarczył niespotykaną do tej pory wydajność, ale również zainspirował kolejne pokolenia inżynierów do tworzenia rozwiązań, które nieustannie popychają granice technologii. Dzięki innowacjom w dziedzinie architektury CPU, dzisiejsze komputery są znacznie potężniejsze, a użytkownicy mają dostęp do narzędzi, które jeszcze kilka lat temu wydawały się nieosiągalne.

Prognozy dla przyszłych architektur CPU

Oczekiwania dotyczące przyszłych architektur CPU są na czołowej linii innowacji w technologii komputerowej. Organizacje i badacze wróżą, że kolejne dekady przyniosą rewolucję nie tylko w wydajności procesorów, ale również w ich efektywności energetycznej oraz możliwościach obliczeniowych. W obliczu rosnącego zapotrzebowania na moc obliczeniową, przyszłe architektury CPU muszą odnaleźć równowagę między wydajnością a oszczędnością energii.

Jednym z kluczowych trendów będzie rozwój procesorów heterogenicznych, które łączą różne typy rdzeni obliczeniowych w jednym chipie. Umożliwi to efektywniejsze wykorzystanie zasobów w zależności od charakteru wykonywanych zadań. W szczególności możemy się spodziewać:

- Integracji rdzeni wysokiej wydajności z rdzeniami oszczędzającymi energię.

- Zwiększenia liczby rdzeni, co pozwoli na lepsze przetwarzanie równoległe.

- Udoskonalenia architektur GPU w celu wsparcia zadań obliczeniowych.

Również, wraz z postępem technologii procesów litograficznych, możemy zobaczyć kolejne zmniejszenie wielkości tranzystorów. Technologia 5nm i mniejsze sprawią, że procesory będą mogły pomieścić setki miliardów tranzystorów na jednostce powierzchni. To pozwoli na:

- Zwiększenie wydajności bez potrzeby zwiększania taktowania.

- Zredukowanie zużycia energii w porównaniu do poprzednich generacji.

- Umożliwienie bardziej zaawansowanych architektur wielordzeniowych.

Nie bez znaczenia będzie także sztuczna inteligencja, która w przyszłości może zdominować procesy projektowania i optymalizacji architektur CPU. Przy pomocy AI możliwe będzie:

- Dostosowywanie architektur do specyficznych zadań w czasie rzeczywistym.

- Ulepszanie algorytmów zarządzania energią i chłodzeniem.

- Optymalizacja przepływu danych w ramach systemów operacyjnych i aplikacji.

Chociaż przewidywanie przyszłości technologii jest zawsze wyzwaniem, możemy być pewni, że nadchodzące architektury CPU przyniosą innowacje, które zmienią sposób, w jaki myślimy o komputerach.Równocześnie koncepcje takie jak użycie materiałów o ultra-niskiej rezystancji, czy nowe metody chłodzenia, będą miały kluczowe znaczenie dla dalszego rozwoju procesorów.

Znaczenie społeczności w rozwoju technologii procesorów

W świecie technologii procesorów, społeczności odgrywają kluczową rolę w ich rozwoju i innowacjach. zróżnicowane grupy ludzi, od inżynierów po entuzjastów, wspólnie współpracują, aby stawać się katalizatorem postępu. Istnieje kilka aspektów, które pokazują, jak społeczności wpływają na ten dynamiczny sektor:

- Otwarte źródła i wspólna praca: Wspólne projekty i platformy open-source pozwalają na dzielenie się wiedzą i doświadczeniem, co prowadzi do bardziej innowacyjnych rozwiązań.

- Feedback i testowanie: Społeczność użytkowników dostarcza cenne opinie,które pomagają w identyfikacji problemów oraz w testowaniu nowych technologii przed ich komercjalizacją.

- Edukacja i zasoby: Dzięki grupom online, forum dyskusyjnym oraz tutorialom, osoby z różnych poziomów zaawansowania mogą zdobywać wiedzę i umiejętności związane z architekturą procesorów.

- Wydarzenia i hackathony: Organizowanie wydarzeń sprzyja zacieśnianiu więzi wśród profesjonalistów branży.To świetna okazja do współpracy oraz wymiany pomysłów.

Technologia CPU zmienia się w zastraszającym tempie, a współpraca w ramach lokalnych i globalnych społeczności przyspiesza proces innowacji. Dzięki zaangażowaniu pasjonatów, nowe rozwiązania dostosowują się do różnych potrzeb rynku, co znacznie wpływa na wydajność i funkcjonalność procesorów. Ważne jest, aby pamiętać, że sukces technologiczny oparty jest nie tylko na pracy inżynierów, ale także na interakcji i współpracy pomiędzy różnymi grupami interesariuszy.

| Rok | wydajność CPU | Innowacje społecznościowe |

|---|---|---|

| 2000 | 500 MHz | Pierwsze fora internetowe dla programistów |

| 2010 | 3 ghz | Powstanie platform open-source |

| 2020 | 5 GHz+ | Wspólne hackathony i szereg projektów społecznościowych |

W każdym z powyższych lat można zaobserwować, że rozwój technologii CPU nie jest tylko kwestią postępu technicznego, ale także wsparcia i aktywności społeczności, które z pasją wprowadzają zmiany i dostosowują nowe rozwiązania do swoich potrzeb.

Wydajność CPU a rozwój technologii mobilnych

Wydajność procesorów oznacza nie tylko szybkość działania urządzeń, ale również ich zdolność do efektywnego zarządzania zasobami w kontekście rozwijającej się technologii mobilnej. Przez ostatnie dekady, w miarę postępu technologicznego, zauważalny jest olbrzymi wzrost mocy obliczeniowej, który zrewolucjonizował sposób, w jaki korzystamy z urządzeń mobilnych.

W produkcji procesorów wykorzystywane są coraz bardziej zaawansowane technologie, co skutkuje:

- Miniaturyzacją komponentów – dzięki technologii 7nm oraz 5nm, możliwe stało się umieszczanie większej liczby tranzystorów na chipie.

- Skalowalnością - nowoczesne procesory potrafią automatycznie dostosowywać swoją moc obliczeniową do aktualnych potrzeb użytkownika.

- Efektywnością energetyczną – zaawansowane techniki produkcji pozwalają na utrzymanie wysokiej wydajności przy niższym zużyciu energii.

Prawdziwą zmianę zauważyć można szczególnie w smartfonach. Od czasów pierwszych urządzeń mobilnych z podstawowymi procesorami, takich jak ARM11, do dzisiejszych potęg, takich jak Apple A16 czy Qualcomm Snapdragon 8 Gen 2, ewolucja była dramatyczna.Różnice w wydajności można zobrazować w tabeli:

| Model Procesora | Rok Wydania | Liczba rdzeni | Częstotliwość (GHz) |

|---|---|---|---|

| ARM11 | 2007 | 1 | 0.4-0.6 |

| Snapdragon 801 | 2014 | 4 | 2.5 |

| Apple A16 | 2022 | 6 | 3.5 |

Od wydajności procesora w dużej mierze zależy także jakość doświadczeń mobilnych użytkowników. Aplikacje stają się coraz bardziej wymagające, co sprawia, że niskobudżetowe urządzenia często nie radzą sobie z najnowszymi technologiami, takimi jak sztuczna inteligencja czy zaawansowana grafika 3D.

W przyszłości oczekiwany jest dalszy rozwój architektur CPU, które będą zdolne obsługiwać coraz bardziej zaawansowane funkcje AI, co podniesie jakość i szybkość działania aplikacji mobilnych, przy świadomości, że efektywność energetyczna musi iść w parze z wydajnością.Już teraz nowe technologie, takie jak procesory heterogeniczne, pokazują potencjał do integracji różnych typów rdzeni, co otwiera drzwi do jeszcze bardziej złożonych zastosowań w świecie mobilnym.

Jak przyszłość 5G wpłynie na wydajność procesorów?

Przemiany związane z technologią 5G, które już teraz zaczynają kształtować naszą rzeczywistość, mają potencjał, aby znacznie wpłynąć na wydajność procesorów w nadchodzących latach. Nowe sieci pozwalają na szybszy i bardziej stabilny transfer danych,co otwiera drzwi do rozwoju nowych aplikacji i usług,które wcześniej były niemożliwe do zrealizowania.

W związku z tym, pojawiają się różnorodne możliwości, które mogą wpłynąć na efektywność obliczeń w procesorach. Kluczowe aspekty to:

- Lepsza współpraca między urządzeniami: 5G umożliwia szybszą komunikację między różnymi urządzeniami, co może prowadzić do bardziej wydajnego wykorzystania mocy obliczeniowej CPU.

- Nowe zastosowania w sztucznej inteligencji: Zwiększenie prędkości przesyłania danych sprawia, że procesory mogą szybciej przetwarzać dane w czasie rzeczywistym, co jest kluczowe dla aplikacji korzystających z AI.

- Większa liczba połączeń: 5G obsługuje znacznie większą liczbę jednoczesnych połączeń, co może wpływać na wymagania dotyczące wydajności procesorów w urządzeniach mobilnych i IoT.

Analizując wpływ 5G na rozwój procesorów, warto zwrócić uwagę na różnice w architekturze, które mogą się stać kluczowe:

| Typ procesora | Wydajność w 4G | Przewidywana wydajność w 5G |

|---|---|---|

| Mobilne CPU | Dobry transfer danych, ale ograniczone możliwości przetwarzania w czasie rzeczywistym | Ekstremalnie szybki, adaptacyjny transfer, lepsze wykorzystanie AI |

| XPU (do zastosowań IoT) | Ograniczone funkcje z powodu mniejszych przepustowości | Wzrost efektywności dzięki szerokiemu pasmu i niskim opóźnieniom |

W przyszłości, w miarę jak sieci 5G będą się rozwijać, można oczekiwać, że producenci procesorów będą wprowadzać innowacje, dostosowując swoje architektury, aby uzyskać maksymalną wydajność w nowym ekosystemie technologicznym. Obliczenia będą mogły przebiegać znacznie szybciej, co z kolei doprowadzi do rozwoju nowych rozwiązań w złożonych zadaniach, które obecnie są poza zasięgiem.

Zmiany te wpłyną nie tylko na sektor mobilny, ale również na przemysł, edukację oraz zdrowie, gdzie wymagana będzie natychmiastowa analiza danych. Z perspektywy użytkownika, oznacza to, że urządzenia będą coraz bardziej inteligentne, a ich wydajność będzie stale rosnąć, co z pewnością będzie miało swoje konsekwencje w codziennym życiu.

Podsumowując, ewolucja wydajności procesorów CPU na przestrzeni ostatnich dekad to fascynująca historia innowacji, postępu technologicznego i nieustannego dążenia do doskonałości. Od pierwszych, prymitywnych układów scalonych, które ledwo zaspokajały potrzeby użytkowników, po potężne, wielordzeniowe jednostki zdolne do przetwarzania złożonych obliczeń w ułamku sekundy – każdy krok tej drogi jest dowodem na to, jak szybko rozwija się nasza technologia.

Dzięki nieprzerwanemu wysiłkowi inżynierów i naukowców, dziś możemy cieszyć się złożonymi aplikacjami, zaawansowaną grafiką i płynnością działania, której jeszcze kilka lat temu nikt by się nie spodziewał. Choć zmiany te są imponujące,to z pewnością możemy spodziewać się jeszcze większego skoku w przyszłości. Jakie innowacje nas czekają? Jak technologia kwantowa wpłynie na architekturę procesorów? Czas pokaże.

Jedno jest pewne – wydajność CPU nadal będzie kluczowym elementem w kształtowaniu naszej cyfrowej rzeczywistości. Dlatego warto śledzić tę dynamiczną dziedzinę i być świadomym wszystkich jej aspektów, aby lepiej rozumieć, jak technologia wpływa na nasze życie. Dziękujemy, że byliście z nami w tej podróży przez historię procesorów! Do następnego razu!